🐹倉鼠週報19:我們的生活是不是悄悄在改變

本篇內容希望透過 AI 讀書這件事來引發讀者們思考,ChatGPT 問世以來已經過了半年,陸續有不同的工具出現,這段時間我們的生活是否發生了一些改變。

卷首語

不知不覺中,每天用 ChatGPT 還有 AI 工具解決各類需求已經成為了日常,最常用的是長篇文章的閱讀理解,正如本篇第四小節會提到的,AI 會改變人們閱讀的方式。

現在因為上下文限制,所以大多用於單篇文章中,但是未來可以用在一整本書的資訊時,至少我自己會有很大的閱讀改變。

像是幫我解釋特定章節的內容、尋找跟特定問題相關的章節,也可以請 ChatGPT 上網延伸相關案例並附上參考連接、上網找特定問題不同觀點的內容等等,檢索特定資訊會變的更有效率。

但 LLM 並不擅長創造新的東西,所以創造新知識的神經元並連接舊有神經元,需要仰賴讀者自身不斷的練習與思考。

🛠️ 本週 AI 新聞 & 工具

1. OpenAI 更新:函數呼叫功能,更長的上下文,更低的價格

這邊直接用列點整理這次更新的重點:

新增 gpt-3.5-turbo 的 16k 上下文版本(相比於標準的 4k 版本)

最先進的 Embedding 模型價格降低 75%,從原本的 $0.004/token 降到 $0.001/token

gpt-3.5-turbo(4k 版本)的輸入 Token 價格降低了 25% 變成 $0.0015/token,輸出維持 $0.0015/token 不變

Chat Completions AP I中加入了 function calling 功能,也就是可以用 api 呼叫 Plugin 了!

開發者可以向 gpt-4-0613 和 gpt-3.5-turbo-0613 描述函數,能讓模型自行判斷是否呼叫 Plugin

https://openai.com/blog/function-calling-and-other-api-updates

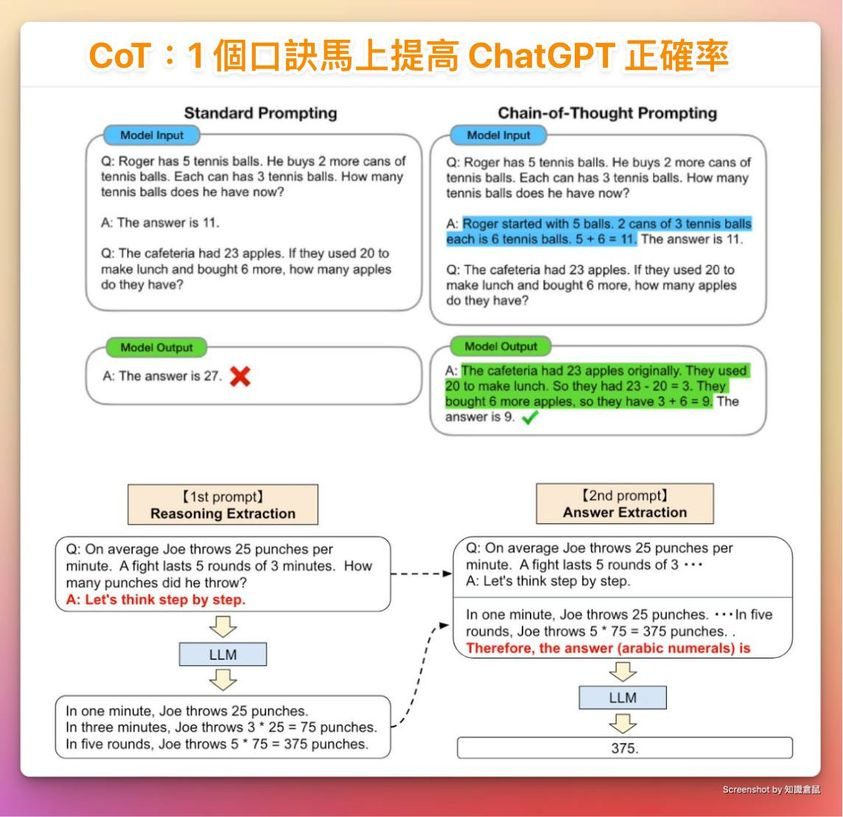

2. CoT:如何更好的運用 AI 解決問題

思考鏈 (Chain-of-Thought):就像是一個人解決問題時的思考過程,這個過程是連續的,每一個思考的步驟都是基於前一個步驟的結果。

比如說,當我們要煮一道料理時會先思考要準備哪些食材、然後怎麼組合、最後怎麼擺盤等。

▎如何用在 ChatGPT 上?

這個技巧幾乎每個提到 Prompt 的教學都會說到,但可能但簡單白話以至於常常被忽略。

只需要在 Prompt 命令中增加一行『請你按步驟思考(Let's Think Step By Step)』就能讓任務成功率大大提升。

但是這個技巧也有一個小缺點,ChatGPT 會先幫你想出一個解決問題的步驟,可是也就只有一個,所以方向錯了可能答案還是會歪樓。

所以如果我們本身就知道解決問題改使用的拆解策略,我們就應該主動先將問題拆分,然後明確具體的告知 ChatGPT 如何執行。

▎思考樹 "Tree Of Thoughts"(ToT)

這個是由普林斯頓大學及 Deepmind 共同提出的語言模型框架,基於 CoT 思考方式向上擴展。

思考樹(ToT)的實現方式也很簡單:

1. 先自己推論出多條解決問題的步驟

2. 個別評估哪個步驟最有效

3. 必要時向前回朔再評估

按照這種方式,AutoGPT 類的自動代理型 AI 就能不斷拆解問題解決問題,直到完成目標任務。

▎ChatGPT 無法取代人類的地方

CoT 及 ToT 看起來真的很直觀,甚至會有一種『這不就是我們的解決問題思考方式嗎!?』

完全正確,但當我們思考解決問題的策略步驟時,會受限於我們的:

知識

經驗

思考能力

立場

資源

綜合以上資訊的能力

至少目前(未來不保證),ChatGPT 類的 LLM 只能基於現有的知識,甚至是很制式的理論框架來提供解決方案。

但這些解決方案缺少了非常多的隱藏知識或背景資訊,導致解決很難有效。

這時人的不可取代性就會出現,知道 AI 的局限性,提供 AI 做不到的思考策略、告知 AI 隱藏的背景資訊。

與 AI 相互配合,我們的決策能力跟解決問題的能力都會更上一層樓。

關於 CoT 的研究論文:

ToT 的研究論文:

3. 簡單4步建自己的藝術 QR Code

前陣子剛看到很漂亮的特色建築 QR Code,這兩天就看到有人將圖片生成功能結合,用在 Discord 上。

先進來這個網站:https://quickqr.art

首先產生自己的 QR Code,輸入你的 URL,然後下載 QR Code 的 PNG 檔。

然後點擊剛剛網站中的 Join Beta 加入 Discord 進入 DC 群。

複製 QR Code 的 URL,然後進入 paste-bin 的頻道後上傳圖片,點擊右鍵複製圖片 URL。

最後輸入 prompt 來產生特色 QR Code

進入 pixelml-box 的頻道,然後輸入 /,選擇 generate 指令。

URL:放上剛剛複製的 QR Code URL。

Prompt:輸入你希望的圖片描述,可看情況加入以下參數,也可不加用預設的就好。

參數說明:

--qrw:QR Weight( QR Code 在圖片上的明顯度,預設 0.8)

--steps:平衡步驟(越多步越有藝術感,太多會影響 QR Code 的可掃描程度,預設 16 步)

--seed:種子碼(固定風格使用)

--presets:藝術家風格

詳細可參考:https://docs.quickqr.art/user-guide/parameter-list

在我寫完教學後兩天,就有人做了能在 huggingface 上生成的工具了,所以也可以直接在這使用:https://huggingface.co/spaces/huggingface-projects/QR-code-AI-art-generator

4. 推薦閱讀:AI 如何改變人們與書籍的關係

這小節是整理自文章『What happens when AI reads a book』一文的心得,原文也推薦一看!

▎用 AI 處理書

目前『生成式 AI』進步非常快,凡事涉及內容的生成都是 AIGC 的一環。

書籍作為一個知識的載體,在印刷術盛行後促成了知識的傳播發展,而且是影響非常巨大。

另一個影響深遠的就是網際網路的誕生,知識與想法可以在世界的各個角落沒有時差的流通。

但這導致了資訊爆炸的現象,對於人們來說獲取知識不再困難,困難的是如何有效的運用這些知識。

這篇文章作者嘗試透過 Claude 來『料理』自己的書,並透過料理的過程來展開『透過 AI 與書籍互動』這件事。

(補充:Claude 也是一個語言模型的機器人,其能力介於 GPT-3.5及 GPT-4 之間,但這篇所用的是上下文一次可容納 10 萬 token 的版本)

料理是我覺得有趣又適合的詞,這些知識就像食材一樣,AI 就是料理知識的新工具。

▎脈絡清晰胡言亂語就消失,練隱喻都能看懂

因為書就是作者寫的,內容是否有幻覺很容易能識別出來。

作者請 AI 解釋每一個書籍提到的觀點及相關研究,AI 答得非常好,並且沒有幻覺(胡言亂語)的情況發生。

甚至作者給出了一個很難的問題,找出書中涉及到隱喻的例子。

因為連要人找出內容的隱喻都是不容易的事情了,對於 AI 來說沒有明顯的『像是』、『就像』一詞,所以這考驗 AI 的能力。

結果是非常出色,雖然給出的答案有一些小瑕疵但整體回答很令作者滿意。

只要上下文足夠清晰,基於給定的內容 AI 都能清晰的回應正確答案。

▎AI 可以取代編輯嗎?

剛剛提到的案例都說是基於現有內容去問的,但是如果請它作為一名編輯,它是否能給出夠好的建議、洞察呢?

答案是一般般。

給出的建議沒有甚麼明顯的問題,但是缺乏深入的洞察力,改寫後的內容也沒甚麼特別吸引人的點。

這也引出一個目前的普遍現況:『優秀的作家比目前的 AI 還要出色』。

創造就是想法的連接,這個連接的動作取決於人對於知識的認知、經驗及立場。

雖然 AI 缺乏深入的洞察力,但在成為一名優秀的編輯(或請它領域的專家)之前,AI 是個能幫人們打好基礎的工具。

▎我的觀察

讀書最好的方式,一定不是整本從頭到尾都讀完,而是按照自己對於知識的需求,從不同章節裡抓出需要的材料來組合。

這個過程就是一種料理資訊的過程,透過需求把資訊料理成一道適合自己的知識。

相較於 Google 的搜尋方式(爬取關鍵字),透過 LLM(大型語言模型)與 AI 互動的方式將會改變人們的閱讀方式。

就像前面所述,只要有足夠的上下文(脈絡),就能解決幻覺出現,但是洞察這件事則需要仰賴讀者『想法的連接』。

文章連接:

5. 科普時間:TryOnDiffusion 快速試衣模型

TryOnDiffusion 是 Google 近期發佈的試衣模型,用來模擬穿搭真是太合適了。

需要用到使用者的一張全身照以及穿著該衣服的模特兒照片,然後透過 Diffusion(擴散)原理來進行合成,等等....擴散是什麼?

首先,我們假設這個 AI 模型是個超級強大的畫家。

這個畫家可以根據他看到的兩張圖片來創作一張新的圖片,這兩張圖片分別是一個人的圖片和一件衣服的圖片。

這個畫家(AI 模型)使用的技術就叫做『Diffusion(擴散)』。

這位畫家會先在一張已經有圖片的畫布上加上一些亂點(這就是所謂的"噪聲"),然後再慢慢地把這些亂點去掉,最後留下的就是他想要的新圖片。

在這個過程中,畫家會參考他看到的兩張圖片,一邊加亂點,一邊去掉亂點,直到他創作出一張新的圖片,這張圖片就是那個人穿上那件衣服的樣子。

那為甚麼這樣就能把衣服穿到另一個人身上?

因為當我們在圖片上加入亂點(噪聲)時,原始的圖片就會被變得模糊不清。

然後當我們逐漸去掉這些亂點時,AI 模型就會嘗試恢復這個圖片。

但是恢復的過程並不是簡單地把亂點去掉,而是需要 AI 模型根據它的訓練和學習,來推測這個圖片在去掉亂點之後應該是什麼樣子。

這個過程中,AI 模型會參考另外一張衣服的圖片。

因為 AI 模型在訓練期間學習了如何將衣物的特性(例如形狀、顏色和紋理)以及人體的結構融入到圖片中。

這樣當 AI 模型在恢復圖片的過程中,它就會嘗試把衣服的圖片融入到人的圖片中,從而創造出一張新的圖片,這張圖片就是人穿上那件衣服的樣子。

這種方法的關鍵在於 AI 模型的訓練和學習。

透過大量的訓練,AI 模型學會了如何把衣服的圖片融入到人的圖片中,從而創造出逼真的人物穿搭圖片。

這就是簡單的 Diffusion(擴散)原理。

Google文章連結:https://blog.google/products/shopping/virtual-try-on-google-generative-ai

模型介紹頁面:https://tryondiffusion.github.io

合成效果: