卷首語

看了一下去年下半年只有寫 4 篇,覺得怎麼這麼混 ==,對不起大家我會努力更新的。

不管走到什麼階段,完美主義永遠會藏在身邊,告訴你『這東西好像還不夠好,先緩緩』,然後就放著偷懶。但成長必須用不斷的『錯誤』去進化,而不是一步到位,提醒我自己,也希望給被完美主義耽誤的人一點提醒。

今年新的方向是從 SEO 跳到 Workflow Automation 的領域中,開課是第一步,再來會嘗試進行企業內訓、協助個人/部門/公司能夠掌握自動化,有興趣歡迎聊聊!

其實這篇標題本來要寫『從資訊獲取來分解 Workflow Automation 的過程』,結果寫了一些前言想法就有點長了,索性當成簡短一篇。

近期問了一些朋友想說可以幫忙自動化這件事,發現一個問題:

大家不知道自己要自動化啥東西。

之前剛好在跟威宇聊這件事時,我有幾個觀察:

自動化工具行之有年了,並不是因為 LLM 才出現的

如果說 LLM 出現前,我們就不會用這些 Workflow Automation 的工具,那大家因為 LLM 而開始用的原因是什麼?

例如 LLM 降低了使用這個工具的成本,或是 LLM 可以協助我們學習新工具。

但前提是大家要知道怎麼搭配使用 LLM。

人數來說:不知道 LLM 的人 > 知道 LLM 的人 > 會用 LLM 的人 > 精通使用的人

再加上 LLM 出現之前就沒什麼用的話,那不意外現在用的人仍不多,這是很正常的。

牙咬著就能做完的事,為什麼要自動化

可能上一代留下刻苦努力的價值觀,讓我們習慣了忍辱負重做事。

有些任務感覺耗時,可是好像牙一咬忍一下就過了,可是為了實現自動化,必須花費十幾二十個小時,而且還不一定有成果。

這是一個必須忍受短期痛苦才能獲得長期回報的過程(而且可能會失敗)。

舉例來說,一般公司內的發送電子報自動化這件事,過程可能是這樣:

蒐集素材

整理內容

整理到 Google Doc

傳送到群組請大家審稿

更新 Email 名單

開啟拖拉式編輯器,複製貼上、複製貼上、上傳圖片、加入錨文字連結

然後過程中有個說麻煩不麻煩,但又很繁瑣的過程『更新電子報名單』。

我們有個客戶總表(Google Sheet),只有特定條件下的客戶可以收到電子報,然後某個欄位會請業務把客戶 mail 填上去。

所以當我們更新名單時應該很簡單吧:篩選某個表特定條件下的所有 email,匯出!

但問題來了:

有些人會填重複的 email

有些人換行

有些人加入分號不換行

有些人打錯格式

有些人忘記填(空白)

這時候自動化就是解決上述問題的時候,但問題又來了:

如果你本來就不熟悉 Google Sheet 公式怎麼辦

問題講不清楚怎麼辦

想要達成的目標講不清楚怎麼辦(Ex:給 LLM 說我希望抓表單的資料成正確格式。『抓啥資料?』、『什麼是正確格式?』)

所以造成很多人在自動化這條路上,在 Google Sheet 公式這一關就卡住了,更不用說什麼用 make、n8n 華麗自動化。

那是不是大家選擇牙咬著,複製所有名單、選單刪除重複及空白、剩下的手動找問題、匯出 csv 上傳平台、平台說哪一筆有問題再回頭重改,往復循環以上步驟。

可能兩三小時就過了。

提高效率可能根本不是一個需求

『同樣的時間,能夠做完這些工作,為什麼要再提升效率,然後多做其它工作?』

並不是每個人都有想要提升效率、展現能力,有時候『舒適圈』意味著我已經習慣了這樣的環境、模式、方法,要人學習新工具本身可能就是需要跨出舒適圈感到累的一件事。

更不用說前面才提到的多個門檻。

不過 LLM + 自動化肯定會是未來的浪潮之一,雖然說今年的熱潮一定會是 AI Agent(代理人),很多人會疑問有代理人不就不用再弄這些自動化了?任務交給 AI,它自己想怎麼達成、然後找工具、執行完成任務。

培養 Workflow Automation 能力的目標就是為了在未來可以與 AI Agent 無縫接軌。

想一下,無論是你還是 AI,目標、方向出來都得不斷 breakdown 成可執行的小目標,但是每個人 breakdown 的方式都不同。業績希望提升一千萬,轉換成戰略層面就有無數種方法。

連定義目標達成可能都不容易,拿『提高品牌忠誠度』為例,怎麼樣可以代表品牌忠誠度,怎麼樣又能算品牌忠誠度『提高了』?

所以你想,如果今天拿到了一個 Agent,我們會怎麼開始溝通、定義目標、制定任務?

設想我們現在拿到一個最簡單的 AI Agent『寫作機器人』,我們會怎麼開始:

寫一篇好文章

寫 SEO 文章

寫文幫助轉換購買

寫就對了?

跟使用 LLM 一樣,工具到我們手上我們一樣要給出清楚的目標、脈絡、策執行略,而訓練好清晰表達與思考能力,就是需要從現在起,Right now,開始訓練。

這跟修煉內功一樣,一輩子的事,內功深厚、根基雄厚,用甚麼武功(工具)才能發揮百倍功力。

近日思考

▍清晰、完整脈絡、細節拉滿的對話才是好的 Prompt

這幾天看到一句話是這麼說的:

越能清晰精準的表達與 AI 溝通,代表你越會使用 AI 而且越會思考。

我們太習慣口語化表達,省略了大量的脈絡資訊,但工作中很多能力好的人往往文字組織能力也很強。

因為這樣的人會去思考怎麼架構文字內容、突出核心、類比說明,並同時考慮讀者認知、換位思考。

所以與其學 Prompt 技巧,真正做到磨刀不誤砍柴功的其實是在一次次對話中,訓練自己更精確的表達。

你會發現原本可能要 15 次來回溝通 AI 才能產出正確的東西,慢慢的變成了 10 次、5 次,這時候就知道你跟 AI 溝通的能力又進步了。

這是一種內功,需要時間修煉,也是所有想用 AI 工具的人需要培養的能力。

▍在跟 AI 溝通來達成 Workflow 自動化時....

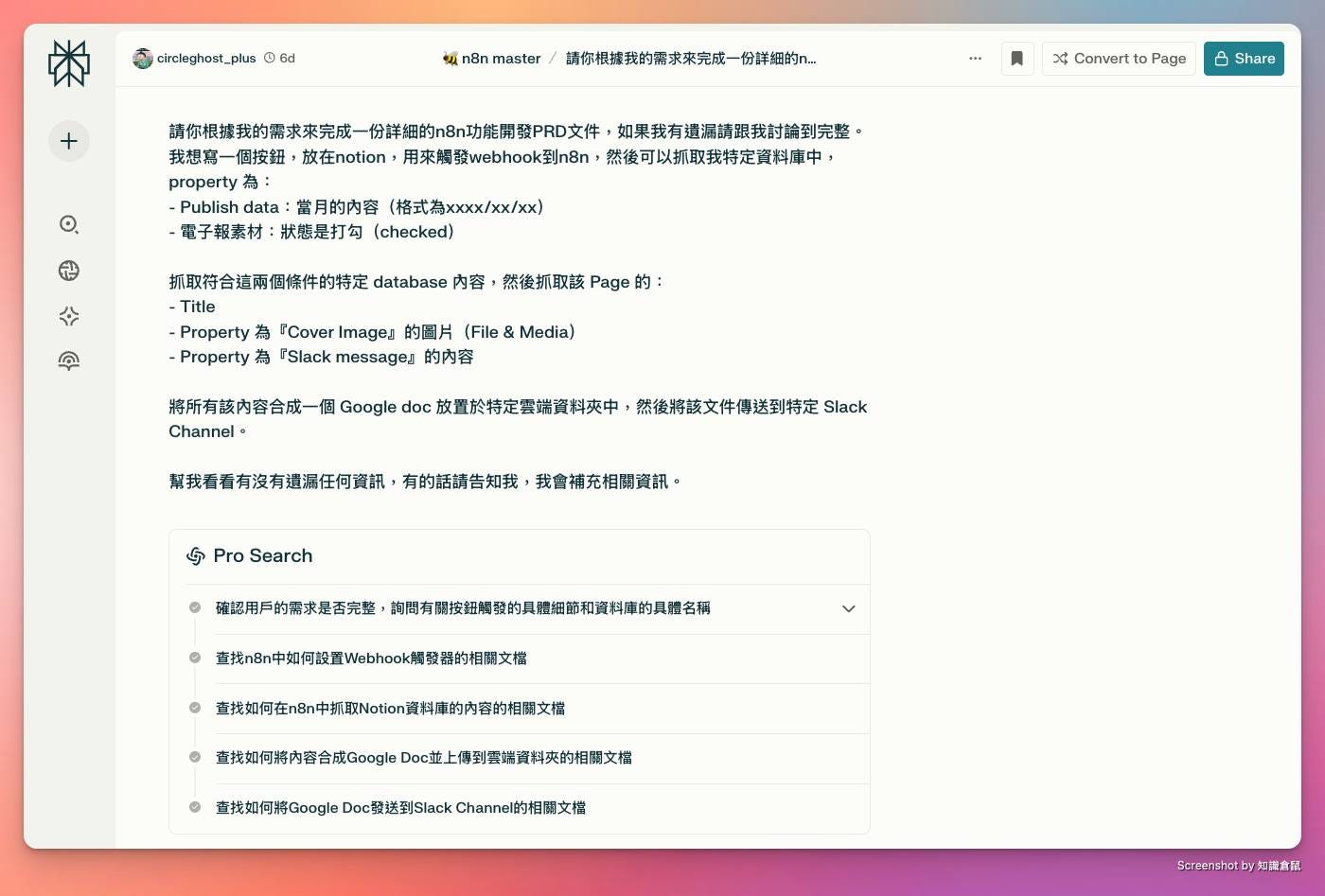

我的 Prompt 開頭為什麼說要用 PRD 文件,就是因為我們是 PM 的角色,先把需求溝通明確再來產生對應的程式,效果會更好。

然後我要怎麼觸發工作流、讀取的是 notion 上哪個 Property,Property 是什麼類型的、最終輸出時的載體是什麼。

所以溝通時會有:

目標:怎麼樣是達成所要的結果

工具:過程使用了哪些工具

資料:每個節點之間接收跟送出的資料可能格式都不同

判斷:節點跟接點之間要設定什麼規則往下走

然後先求有再求好,也許一開始的接點很亂,但是達成了目標。再來就是進一步思考這個流程能夠怎麼再優化。

是不是有更好的工具、是不是有些步驟可以省略、原來有人做過類似的功能/API 了等等的。

然後就會越來越進步,能力也會越來越強。

Prompt 如下給大家參考:

```

請你根據我的需求來完成一份詳細的n8n功能開發PRD文件,如果我有遺漏請跟我討論到完整。

我想寫一個按鈕,放在notion,用來觸發webhook到n8n,然後可以抓取我特定資料庫中,property 為:

Publish data:當月的內容(格式為xxxx/xx/xx)

電子報素材:狀態是打勾(checked)

抓取符合這兩個條件的特定 database 內容,然後抓取該 Page 的:

Title

Property 為『Cover Image』的圖片(File & Media)

Property 為『Slack message』的內容

將所有該內容合成一個 Google doc 放置於特定雲端資料夾中,然後將該文件傳送到特定 Slack Channel。

幫我看看有沒有遺漏任何資訊,有的話請告知我,我會補充相關資訊。

```

▍AI Search 的趨勢之一:小心 JS 渲染內容 AI 抓不到

JS 渲染幾乎是現在網頁必備的項目了,各種特效、拉資料等等的很好用。

可是諸如 ChatGPT 等 LLM 工具在渲染 JS 上做的並不好,目前做的最好的還是只有 Google,但你一定希望你的內容可以在各種問答上出現吧。

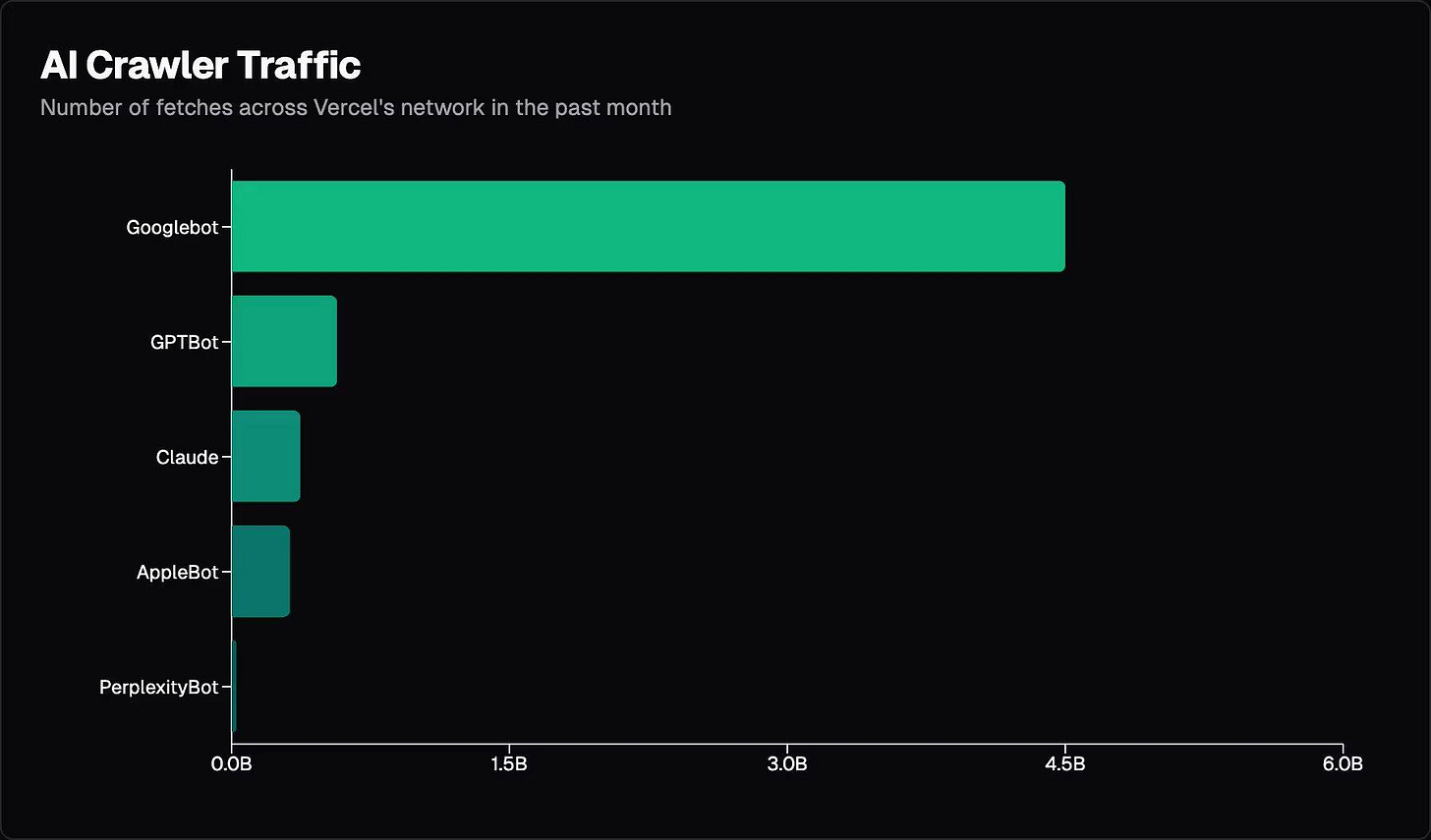

Vercel 出了一篇文章,由 MERJ 和 Vercel 共同進行。研究團隊通過監測 nextjs.org 和 Vercel 網路收集數據,同時分析了使用不同技術架構的網站。

目的是為了深入了解主要 AI 爬蟲(如 ChatGPT、Claude 等)如何爬取和處理網路內容。

▍在 JavaScript 渲染能力方面各爬蟲存在明顯差異。

大多數主要 AI 爬蟲,包括 OpenAI、Anthropic、Meta 和 ByteDance 的爬蟲都不執行 JavaScript。

雖然 ChatGPT 和 Claude 會抓取 JavaScript 文件,但並不執行這些程式碼。相比之下,Google 的 Gemini 和 AppleBot 具備完整的 JavaScript 渲染能力。

▍內容類型優先順序

不同 AI 爬蟲在內容類型偏好上表現出明顯差異。ChatGPT 主要關注 HTML 內容,占其請求的 57.7%;Claude 則更注重圖片內容,占 35.17%。Googlebot 的內容獲取更加均衡,HTML、JSON、純文本和 JavaScript 的比例相對平均。

▍爬蟲效率問題

AI 爬蟲在效率方面仍面臨重大挑戰。ChatGPT 和 Claude 約有 34% 的請求遇到 404 錯誤,ChatGPT 還有 14.36% 的請求需要轉址。

看看 Googlebot 僅有 8.22% 的 404 錯誤率形成鮮明對比,很明顯 AI 爬蟲在 URL 選擇和處理策略上還有很大的進步空間,Google 還是最強。

▍會有什麼問題?

由於大多數 AI 爬蟲不執行 JavaScript,動態渲染的內容可能無法被正確獲取;

高達 34% 的 404 錯誤率意味著 AI 工具提供的 URL 可能不可靠;

資料的新鮮度也可能不一致,即使 AI 聲稱獲取了最新資訊,實際上可能使用的是快取或訓練數據。

▍前面看不懂沒關係,看結論

雖然有人鼓吹技術無用,Content 為王,但你的內容 AI 看不到就不會被引用喔。

網站管理員應該跟技術人員討論:

重要內容是否一定需要透過 JavaScript 來渲染?

是不是能將重要內容先在原本的 HTML 中呈現讓爬蟲可以抓到。

渲染資源是否過重過多導致 AI 爬蟲沒有爬到正確資源就離開了?

awoo 團隊對於 AI Search 非常關注,團隊對於國外專家的看法也非常深入在研究,對於語言模型如何影響 SEO、搜尋的未來更是不斷在進行沙盤推演。

技術面確實不是每個都需要優化,但是關鍵部分如果沒有留意,可能連參與競爭的資格都沒有。

研究報告雙語翻譯版本:

我花了整整一個月的時間想搞一個 AI SEO 寫作 Agent,然後才發現自己根本不懂寫作....